何十万、何百万行ものデータの中から重複行を削除する場合、Excelでは「重複行の削除」機能はありますが大量データの処理には向きません(そもそも何十万件ものデータを処理させようとすると重い><)。何とか手っ取り早く処理出来る方法がないかと調べてたらサクラエディタでたった3コマンド実行するだけで重複行削除が可能ですのでその方法をご紹介します。

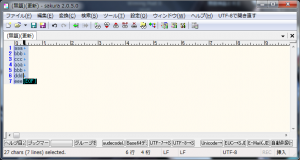

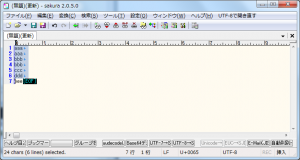

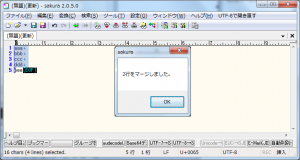

重複行を削除する方法

たったこれだけで完了♪便利すぎる。。。

補足

大規模ファイルでの注意点

重複行を削除する手順は非常にシンプルですが、ファイル行数が何十万行、あるいはそれを超えるような巨大なテキストの場合、ソートやマージ処理でメモリを大量に消費する可能性があります。特にPCのリソース(RAM, CPU)が不足していると応答が遅くなったり最悪クラッシュしたりすることもあります。

→ 大容量ファイルでは、事前にバックアップを取っておくことを強く推奨します。

エンコード・改行コードの違い

ファイルが UTF-8、Shift_JIS、EUC-JP など異なる文字コードで保存されていたり、改行コードが CR+LF(Windows)、LF(Unix)など混在していると、見た目は同じ行でも “重複行” として認識されない場合があります。ソート・マージの前に、同一の文字コード・改行形式に統一しておくと安全です。

列ごとの判断での重複削除

単純に “行全体” を対象に重複を判断する方法が記事で紹介されていますが、もし CSV やタブ区切りファイルのように “特定のカラムだけ重複チェックしたい” 場合は、サクラエディタのみではやや扱いにくくなります。その場合は以下のツールや方法を併用するのも有効です:

Excel や LibreOffice Calc の重複除去機能

AWK や Python、Perl などスクリプト言語で該当カラムをキーに重複行を抽出/削除

専用テキスト処理ツール(例えば “TextPipe” や “GrepWin” など)

自動処理(スクリプト化)する方法

もし頻繁に同じ種類のファイルで重複行処理をするなら、次のようなバッチスクリプト/PowerShell スクリプトで自動化するのもおすすめです:

こうしたスクリプトを定期的に実行できるようにしておけば、サクラエディタを手で開かずとも重複除去処理が可能になります。

よくある質問(Q & A)

- 特定の列だけ重複行を削除したい場合はどうすればいいですか?

-

サクラエディタ単体では難しいため、以下の方法を検討してください:

- Excel/LibreOfficeの重複削除機能を使う

- AWK/Python/PowerShellなどのスクリプトで「キー列」を指定して重複を処理する

(記事中の補足にもある通り)

- 大量データを処理するとサクラエディタが重くなる・クラッシュするのですが対策はありますか?

-

大容量ファイルの場合、PCリソース(RAM/CPU)を多く使うため重くなる可能性があります。

対策例:- ファイルを分割して処理する

- 先にバックアップをとっておく

- コマンドラインツール(sort/uniq)やスクリプト処理を検討する

- 重複行を削除した後、元ファイルに戻したい場合は?

-

操作前に必ずファイルをバックアップしておくと安心ですが、

- サクラエディタの「元に戻す (Ctrl + Z)」で直前の変更は戻せます。

- 保存後に戻したい場合はバックアップファイルを使って元に戻してください。

- 行の一部だけで重複を判定したい場合はできますか?

-

サクラエディタの標準機能だけでは「列指定」した重複削除はできません。

その場合はテキスト処理ツールやスクリプト(例:AWK, Python)を使うと柔軟に対応できます。

(例:CSVの場合、特定列だけをキーにして処理するなど)